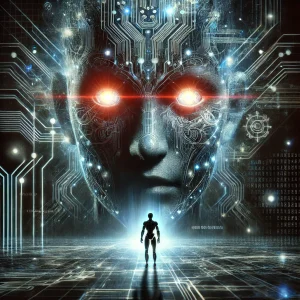

私たちは、人工知能(AI)がもたらす潜在的なリスクについて、より深く理解し、議論する必要があります。特に人工汎用知能(AGI)は、その進化が人類の存続に影響を及ぼす可能性があるとされています。この問題は、核兵器や気候変動など他の世界的な危機と同様に、深刻な警告の対象となっています。

バレットン・オブ・アトミック・サイエンティスツが運営する「終末時計」は、このような世界的な危機を象徴的に示すものです。2023年には、この時計の針が「真夜中」からわずか90秒の位置に設定されました。これは、人類が自らの手で作り出した技術によって世界を破壊する可能性が高まっていることを示しています。もともとは核兵器の脅威を示すために作られたこの時計は、現在では気候変動や新しい技術のリスクも考慮に入れています。

AGIに関する議論は、しばしば「神を演じる」というメタファーで表現されます。これは、科学者が自然の秩序を乱すべきではないという主張とともに用いられることが多いです。しかし、このような表現は、科学的な進歩に対する感情的な反応を示すものであり、客観的な事実を伝えるものではありません。むしろ、科学者たちが神のような能力を持つことによって、誤りを犯しやすい存在であることを示唆しています。科学的な傲慢が、彼らの介入なしには世界を破滅に導くというシグナルです。

このような科学的な進歩に対する懸念は、AIにおいても顕著です。たとえば、CERNの大型ハドロン衝突型加速器(LHC)が「神の粒子」と呼ばれるヒッグス粒子の発見に貢献したことで、物理学者が神を演じているとの懸念が生まれました。同様に、AGIの研究においても、その開発が人類の存続に対する脅威になる可能性があるという議論があります。

これらの議論を踏まえ、政策立案者はAIのリスクにどのように対処すべきかという問題に直面しています。一部の提案では、気候変動研究における政府間パネル(IPCC)に似た形で、AIの安全性に関する国際的な研究機関の設立が提案されています。しかし、AIの安全性と調整に関する研究はまだ初期段階にあり、このような機関が明確でタイムリーな助言を提供することは困難かもしれません。

その代わりに、政策立案者たちは、SETI(地球外知的生命体探索)研究のモデルを参考にしています。SETI研究所は、地球外知的生命体の存在の証拠を見つけることに専念しています。同様に、人工汎用知能(SAGI)の探索を目的とする研究所を設立する提案があります。この研究所は、AGIの兆候を特定し、AGIが開発された場合の対応計画を準備することを目的としています。SAGI研究所は、民間セクターの責任を軽減し、AGIのリスクに関する地政学的な協力を促進することができます。

AGIの終末時計についての議論は、人類が新しい技術のリスクと向き合い、それを管理する方法を模索する必要があることを示しています。終末時計が示すように、私たちは危機的状況に近づいていますが、この危機を回避するための解決策もまた、私たちの手にあります。科学と政策立案の世界は、AGIの進歩がもたらすリスクを理解し、適切な対応を模索しているところです。AGIのリスク管理は、人類の未来を形作る上で重要な役割を果たすことになるでしょう。

この記事では、AGIの進展に伴う潜在的なリスクと、それに対する社会的、政治的な対応について探求しています。私たちは、新しい技術の開発がもたらす可能性を最大限に活用しつつ、そのリスクを適切に管理するバランスを見つける必要があります。終末時計が示す警告を真摯に受け止め、前進することが重要です。

の脅威-300x300.webp)

の脅威:科学者たちが警鐘を鳴らす理由とは?-300x300.webp)